Optimización de Inferencia para Modelos de IA en Dispositivos Edge: Técnicas y Estrategias Avanzadas

Introducción

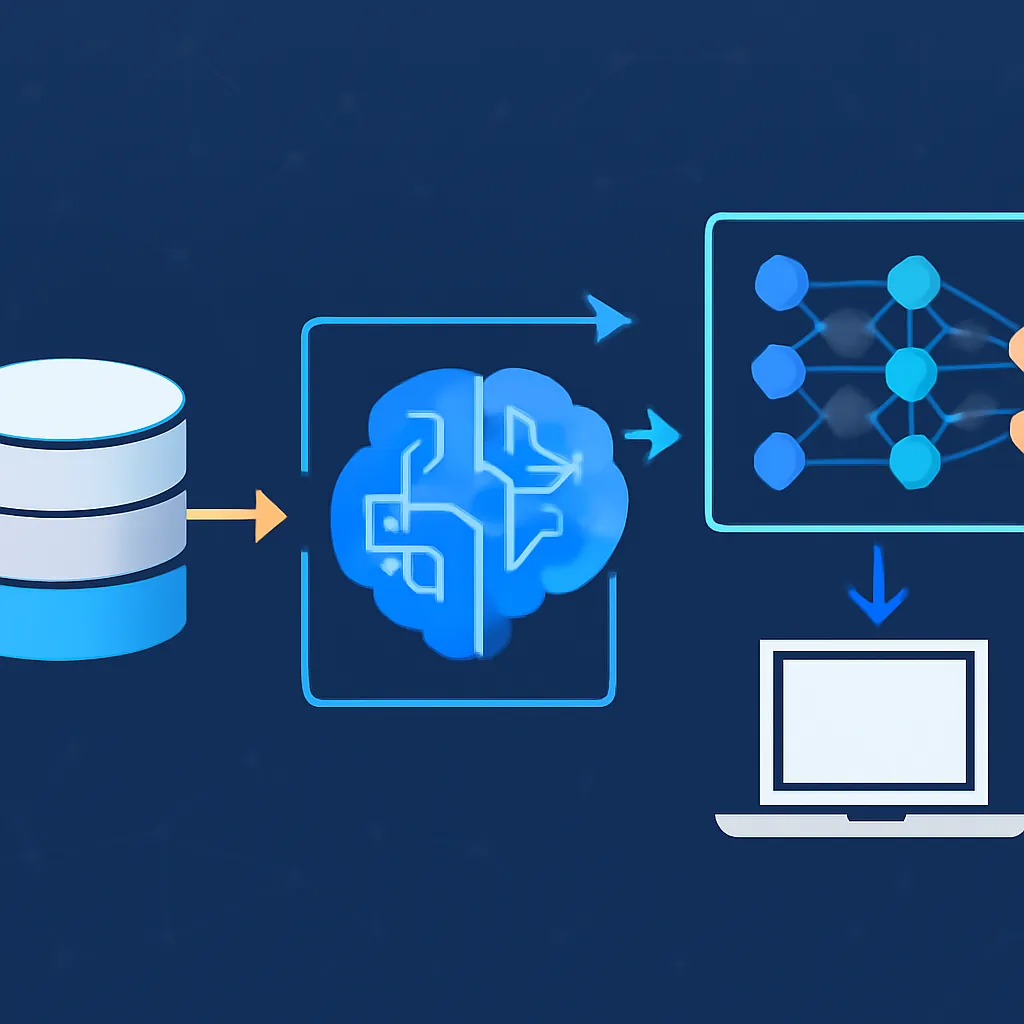

La computación en dispositivos edge ha emergido como un pilar fundamental para aplicaciones de inteligencia artificial en tiempo real, con requerimientos estrictos de latencia, privacidad y eficiencia energética. Sin embargo, la limitada capacidad computacional y recursos restringidos de memoria y energía en edge devices representan un gran desafío para desplegar modelos de IA complejos y de gran escala.

Este artículo explora con profundidad técnicas avanzadas para la optimización de inferencia de modelos de inteligencia artificial en dispositivos edge, cubriendo desde la cuantización y poda, hasta arquitecturas ligeras y compiladores especializados, proporcionando un marco para lograr implementaciones robustas sin sacrificar rendimiento ni precisión.

Desafíos en la Inferencia en Edge Devices

- Recursos limitados: Capacidad computacional reducida, baja memoria RAM y almacenamiento restringido.

- Consumo energético: Importancia crítica en dispositivos con baterías o alimentación limitada.

- Requisitos de latencia: Procesamiento en tiempo real para casos de uso como visión por computadora, reconocimiento de voz, IoT o robótica.

- Conectividad intermitente: Necesidad de ejecutar modelos localmente sin depender de la nube.

Técnicas Avanzadas para Optimizar Inferencia en Edge

Cuantización de Modelos

La cuantización reduce la precisión numérica de los pesos y activaciones de un modelo, disminuyendo el tamaño y acelerando los cálculos. Las variantes más utilizadas incluyen:

- Post-training quantization: Cuantización después del entrenamiento, comúnmente a 8 bits.

- Quantization-aware training (QAT): El modelo se entrena considerando la reducción de precisión para minimizar pérdida de precisión.

Ejemplo en TensorFlow Lite para cuantización dinámica:

import tensorflow as tf converter = tf.lite.TFLiteConverter.from_saved_model('modelo_saved') converter.optimizations = [tf.lite.Optimize.DEFAULT] tflite_model = converter.convert() with open('modelo_quantized.tflite', 'wb') as f: f.write(tflite_model)Poda Estructurada y No Estructurada

La poda elimina conexiones o neuronas menos significativas para reducir el tamaño y mejorar la eficiencia. Se clasifica en:

- Poda no estructurada: Elimina pesos individuales, puede requerir hardware especializado para aprovechar la sparsity.

- Poda estructurada: Elimina bloques cohesivos como filtros o canales, más amigable para hardware estándar.

Ejemplo simple con PyTorch para poda estructurada:

import torch import torch.nn.utils.prune as prune model = ... # modelo preentrenado # Poda del 30% de filtros en la primera capa convolucional prune.ln_structured(model.conv1, name='weight', amount=0.3, n=2, dim=0) # Para hacer la poda permanente prune.remove(model.conv1, 'weight')Arquitecturas Ligeras y Redes Neurales Compactas

Integrar modelos diseñados para eficiencia computacional como MobileNetV3, EfficientNet-lite o GhostNet reduce la complejidad sin perder precisión significativa. Estas arquitecturas usan bloques optimizados, convoluciones separables y técnicas avanzadas de diseño.

Compiladores y Frameworks Optimized para Edge

Herramientas como TensorRT, TVM, OpenVINO o ONNX Runtime permiten compilar modelos para que utilicen las instrucciones específicas y optimizaciones de hardware del edge device, acelerando la inferencia de forma significativa.

Uso de Precisión Mixta

Combinar diferentes precisiones numéricas para distintas partes del modelo (por ejemplo, FP16 para la mayoría y FP32 para capas críticas) mejora el equilibrio entre eficiencia y exactitud.

Optimización del Pipeline de Inferencia

Reducir el tiempo total de inferencia incluye además optimizar pre-procesamiento, post-procesamiento y reducción de transferencias de datos, idealmente integrándolos para evitar cuellos de botella.

Comparativa de Técnicas de Optimización

| Técnica | Ventajas | Inconvenientes | Impacto en Precisión |

|---|---|---|---|

| Cuantización | Disminuye tamaño y mejora velocidad | Ejemplos: pérdida ligera de precisión, requerimientos hardware específicos | Baja a moderada |

| Poda | Reduce complejidad, puede aprovechar sparsity | Poda no estructurada difícil para hardware común | Variable, depende de grado de poda |

| Modelos ligeros | Diseñados para eficiencia, buen desempeño | Reentrenamiento requerido para necesidades específicas | Generalmente baja |

| Compiladores optimizados | Aprovechan hardware específico, aceleran inferencia | Complejidad en configuración y mantenimiento | Sin impacto en precisión |

Ejemplo Integrado: Cuantización y Uso de TensorRT

A continuación un ejemplo básico de cómo convertir un modelo PyTorch a ONNX y luego usar TensorRT para optimización y despliegue en dispositivo edge con GPU NVIDIA:

import torch

import torch.nn as nn

import tensorrt as trt

import pycuda.driver as cuda

import pycuda.autoinit

# Modelo PyTorch dummy

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.fc = nn.Linear(10, 5)

def forward(self, x):

return self.fc(x)

model = SimpleModel().eval()

# Exportar a ONNX

input_data = torch.randn(1, 10)

torch.onnx.export(model, input_data, 'model.onnx', input_names=['input'], output_names=['output'], opset_version=11)

# Construcción básica de TensorRT engine

TRT_LOGGER = trt.Logger(trt.Logger.WARNING)

builder = trt.Builder(TRT_LOGGER)

network = builder.create_network()

parser = trt.OnnxParser(network, TRT_LOGGER)

with open('model.onnx', 'rb') as model_onnx:

parser.parse(model_onnx.read())

builder.max_batch_size = 1

builder.max_workspace_size = 1 << 20 # 1MB

engine = builder.build_cuda_engine(network)

# El engine es ahora listo para inferencia de baja latencia en GPU edge

Mejores Prácticas y Consideraciones Finales

- Evaluar impacto en precisión: Siempre validar rigurosamente las optimizaciones para garantizar que la caída en precisión sea aceptable o nula.

- Perfilar continuamente la inferencia: Identificar cuellos de botella y puntos de mejora con herramientas específicas del hardware.

- Combinar técnicas: La unión de cuantización, poda y compilación generalmente entrega mejores resultados que usar una sola.

- Documentar y versionar: Controlar los cambios para reproducibilidad y mantenimiento con sistemas como DVC o MLflow.

- Considerar hardware específico: Adaptar optimizaciones al dispositivo objetivo para maximizar eficiencia.

Conclusión

La optimización de la inferencia para modelos de IA en dispositivos edge es un campo crítico que combina técnicas avanzadas de machine learning, ingeniería de software y conocimiento profundo del hardware objetivo. El uso inteligente de cuantización, poda, arquitecturas eficientes y compiladores optimizados facilita llevar modelos complejos a entornos restrictivos, abriendo paso a aplicaciones reales en tiempo real con máxima eficiencia.

Estar al día con estas técnicas y adaptar el pipeline de despliegue es esencial para cualquier ingeniero o científico de datos que busca maximizar el impacto de sus soluciones de IA en el mundo real.