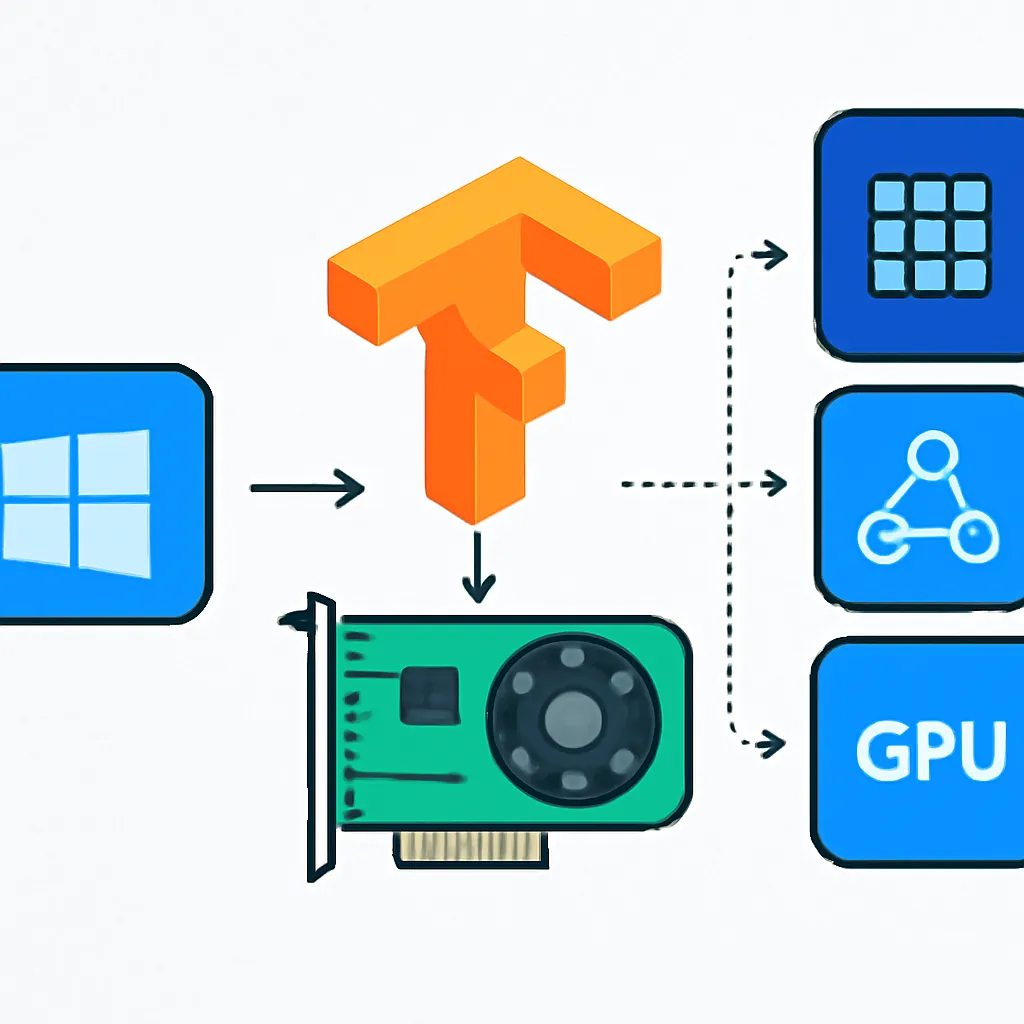

Guía Completa para Configurar un Entorno de Desarrollo en TensorFlow con GPU en Windows

En esta guía didáctica y práctica, aprenderás paso a paso cómo instalar y configurar un entorno de desarrollo para TensorFlow con soporte para GPU en Windows. Este tutorial está pensado para usuarios principiantes que desean aprovechar la potencia de la aceleración por GPU para entrenar modelos de deep learning de forma eficiente.

¿Por qué usar TensorFlow con GPU?

TensorFlow es uno de los frameworks más populares para desarrollo de inteligencia artificial. Cuando entrenamos modelos grandes, el uso de la GPU puede acelerar significativamente el proceso, gracias a su arquitectura paralela optimizada para operaciones matriciales y tensoriales.

Sin embargo, configurar TensorFlow para que utilice la GPU en Windows puede ser un desafío inicial debido a la necesidad de dependencias específicas como CUDA y cuDNN.

Requisitos Previos

- Windows 10 o superior (64 bits).

- Tarjeta gráfica NVIDIA compatible (Kepler o superior).

- Versión reciente de Python (preferiblemente 3.8 o superior).

- Acceso administrativo para instalar controladores y software.

- Conexión a internet para descargar paquetes y librerías.

Paso 1: Actualizar y Verificar Drivers NVIDIA

- Visita el sitio oficial de NVIDIA: https://www.nvidia.com/Download/index.aspx

- Descarga y instala la última versión del controlador para tu GPU.

- Reinicia tu computadora para aplicar cambios si es necesario.

Una GPU correctamente configurada es imprescindible para que TensorFlow detecte el hardware.

Paso 2: Instalar CUDA Toolkit

CUDA es una plataforma de computación paralela y modelo de programación desarrollado por NVIDIA para usar la GPU con aplicaciones generales.

- Revisa la compatibilidad de versiones de TensorFlow y CUDA en la página oficial: TensorFlow GPU Support.

- Descarga la versión de CUDA Toolkit compatible desde: https://developer.nvidia.com/cuda-downloads

- Instala siguiendo las instrucciones predeterminadas.

- Verifica la instalación abriendo una terminal y ejecutando:

nvcc --version

Paso 3: Instalar cuDNN

cuDNN es una biblioteca de primitivas GPU para redes neuronales profundas, optimizada para un rendimiento máximo con TensorFlow.

- Regístrate y descarga cuDNN desde NVIDIA Developer.

- Extrae el contenido y copia las carpetas bin, include y lib dentro del directorio de instalación de CUDA (normalmente

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vXX.X\). - Agrega a la variable de entorno

PATHlos directorios:C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vXX.X\binC:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\vXX.X\libnvvp

Paso 4: Crear un Entorno Virtual en Python

Para evitar conflictos con otras librerías y mantener el entorno limpio, es recomendable usar un entorno virtual:

python -m venv tf_gpu_env

. f_gpu_env\Scripts\activateEste comando crea y activa un entorno virtual llamado tf_gpu_env.

Paso 5: Instalar TensorFlow con Soporte GPU

Con el entorno activado, instala TensorFlow compatible con GPU:

pip install --upgrade pip

pip install tensorflowNota: Desde TensorFlow 2.x, el paquete tensorflow incluye soporte GPU si el hardware y drivers están listos.

Paso 6: Verificar Instalación y Uso de GPU en TensorFlow

Ejecuta el siguiente script de Python para comprobar que TensorFlow detecta la GPU:

import tensorflow as tf

print("Versión TensorFlow:", tf.__version__)

physical_devices = tf.config.list_physical_devices('GPU')

print("GPUs disponibles:", physical_devices)

if physical_devices:

print("TensorFlow está listo para usar la GPU.")

else:

print("GPU no detectada. Verifica la instalación.")Si la salida lista tu GPU, ¡felicidades! Estás listo para entrenar modelos acelerados.

Consejos Adicionales

- Siempre verifica las versiones de CUDA y cuDNN compatibles con tu versión de TensorFlow para evitar incompatibilidades.

- Si usas Conda, el paquete

cudatoolkitpuede gestionarse desde el entorno para simplificar la instalación. - Consulta los logs de TensorFlow para confirmar que se están asignando recursos GPU durante el entrenamiento.