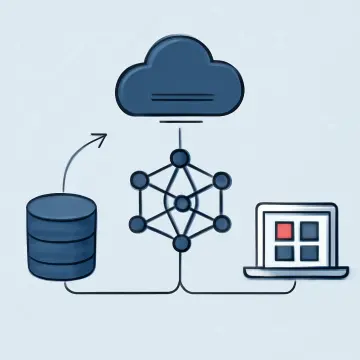

El artículo aborda el diseño avanzado de modelos de lenguaje a través de la arquitectura Mixture of Experts (MoE), que permite un crecimiento masivo en parámetros sin incurrir en costos computacionales lineales. Se detalla cómo funciona el módulo gating para la selección dinámica de expertos, la implementación técnica básica en PyTorch y prácticas para balancear y optimizar el entrenamiento. También se presentan casos reales como Google GLaM y Switch Transformer, y se discuten los retos técnicos asociados. Finalmente, se concluye resaltando la importancia de MoE para la escalabilidad eficiente de LLMs en aplicaciones industriales y de investigación de punta.